La capacidad de una IA para mantener una conversación coherente y procesar información depende directamente de su "ventana de contexto". En Tess AI o en cualquier otra plataforma, entender cómo funciona esta ventana es clave para optimizar tus interacciones, ya sea en charlas directas, al analizar documentos o al crear agentes. Este artículo explora el concepto de ventanas de contexto, los tokens y cómo puedes manejar esos elementos para obtener los mejores resultados en la plataforma.

Cada interacción con un modelo de IA ocurre dentro de una "ventana de contexto". Piensa en ella como la memoria a corto plazo de la IA durante una charla o tarea específica. Esta memoria se mide en tokens. Los tokens no son simplemente palabras; son unidades de texto que los modelos de IA usan para procesar y entender el lenguaje. Una palabra puede ser un token, parte de un token o varios tokens, según su complejidad y el idioma.

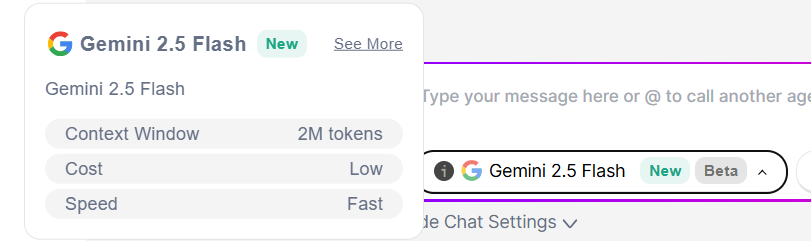

Cada modelo de IA disponible en Tess AI, como las variaciones de GPT o Gemini, tiene una cantidad máxima de tokens para su ventana de contexto. Por ejemplo, el modelo GPT-4.1 Nano puede soportar hasta 1 millón de tokens, mientras que GPT-4o Mini soporta 128.000 tokens y algunos modelos Gemini pueden llegar a 2 millones de tokens.

Es importante tener en cuenta que esa cantidad de tokens incluye tanto tus entradas (preguntas, instrucciones, archivos enviados) como las respuestas generadas por la IA (respuestas, textos creados).

Cuando la cantidad de tokens en una interacción se acerca o supera el límite de la ventana de contexto del modelo elegido, la IA puede empezar a mostrar comportamientos inesperados. Esto puede incluir perder información previa de la conversación, respuestas menos coherentes, o lo que se conoce comúnmente como "alucinación" (generar información incorrecta).

Para ayudar a los usuarios, Tess AI muestra un aviso que aparece cuando la conversación se está haciendo muy larga y se acerca al límite de la ventana de contexto, sugiriendo abrir un chat nuevo.

Paso a paso: Cómo ver la ventana de contexto de un modelo

En AI Copilot, en el área de chat, haz clic en el selector de modelos.

Al lado del nombre del modelo que quieres, vas a ver un pequeño ícono de información (una "i" dentro de un círculo).

Haz clic en ese ícono para ver detalles del modelo, incluyendo su "Context Window" (Ventana de Contexto) en tokens.

Tip: Si prevés una interacción larga o necesitas dar mucha información, elige modelos con ventanas de contexto más grandes desde el principio.

Una de las funciones chéveres de Tess AI es que puede analizar archivos, como PDFs, hojas de cálculo (Sheets, Excel) y documentos (Docs). La forma en que subes esos archivos a la Base de Conocimiento impacta directamente en el uso de la ventana de contexto.

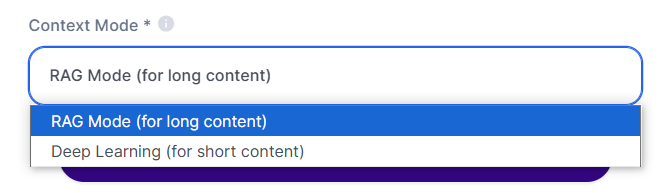

Al agregar un archivo a la Base de Conocimiento, vas a encontrar dos opciones principales en el "Modo de Contexto":

Modo Deep Learning:

Ideal para: Archivos pequeños (ej: PDFs de pocas páginas).

Cómo funciona: La IA lee todo el archivo de una sola vez, metiendo todo su contenido en el contexto.

Consumo de créditos: Solo pasa una vez, cuando se lee el archivo entero (alrededor de 20 créditos)

Impacto en la ventana de contexto: Todo el contenido del archivo va a ocupar una parte de la ventana de contexto del modelo.

Modo RAG (RAG - Retrieval Augmented Generation):

Ideal para: Archivos grandes (ej: PDFs largos, hojas de cálculo grandes).

Cómo funciona: La IA parte el archivo en varios "trozos" (chunks). Cuando preguntas algo, la IA busca y analiza sólo las partes relevantes para responder, en vez de procesar todo el archivo cada vez.

Consumo de créditos: Pasa cada vez que una pregunta necesita buscar y analizar partes del archivo. (normalmente es muy bajo)

Impacto en la ventana de contexto: Mucho más eficiente para archivos grandes, porque solo los trozos relevantes se pasan al contexto cuando preguntas, así que casi toda la ventana queda disponible para la interacción.

Mejor práctica: Para documentos cortos y análisis rápidos, el Deep Learning puede ser suficiente. Para documentos voluminosos o cuando necesitas consultar partes específicas de un material extenso repetidamente, el Modo RAG es la opción más estratégica, ya que optimiza el uso de la ventana de contexto y, potencialmente, el consumo de créditos a largo plazo.

Si sueles hacer tareas repetitivas que necesitan un conjunto específico de instrucciones o conocimiento, o si tus conversaciones suelen extenderse mucho, llegando a los límites de contexto, crear un Agente de IA en el AI Studio es una solución genial.

Al crear un agente, das instrucciones detalladas (prompt) y hasta puedes adjuntar bases de conocimiento específicas solo una vez. Ese "entrenamiento" inicial se guarda en el agente.

¿Cómo ayuda esto con la ventana de contexto? Cada nuevo chat que inicias con tu agente personalizado empieza con una ventana de contexto "limpia" para la interacción en sí, pero el agente ya tiene todo el conocimiento y las reglas que configuraste. Esto significa que no tienes que repetir instrucciones largas cada vez que empieces una nueva conversación, ahorras tokens y mantienes las interacciones más cortas y directas.

Para aprender a crear un agente, entra en nuestro otro artículo!

Si, incluso con las estrategias de arriba, llegas al límite de contexto en un chat y la IA te sugiere empezar una nueva conversación, el historial de la conversación actual no se transfiere automáticamente.

Solución paliativa:

Copia las partes más importantes de tu conversación anterior.

Empieza un chat nuevo, preferiblemente con un modelo de IA que tenga una ventana de contexto más grande.

Pega el historial copiado en el nuevo chat para darle a la IA el contexto necesario.

Mirando al futuro: Tess AI está desarrollando una función increíble llamada "Tess Memories", que te permite guardar información y contextos específicos para usarlos en diferentes chats, haciendo más fácil continuar y personalizar las conversaciones sin tener que copiar y pegar todo el tiempo. ¡Vale la pena probarlo!